火花监测

最后修改时间:2023 年 12 月 6 日使用Spark插件,您可以直接在 IDE 中监控Spark集群和提交的作业。

在这一章当中:

笔记

除了手动创建连接之外,如果您在 AWS EMR 集群上运行 Spark,您还可以快速创建连接。

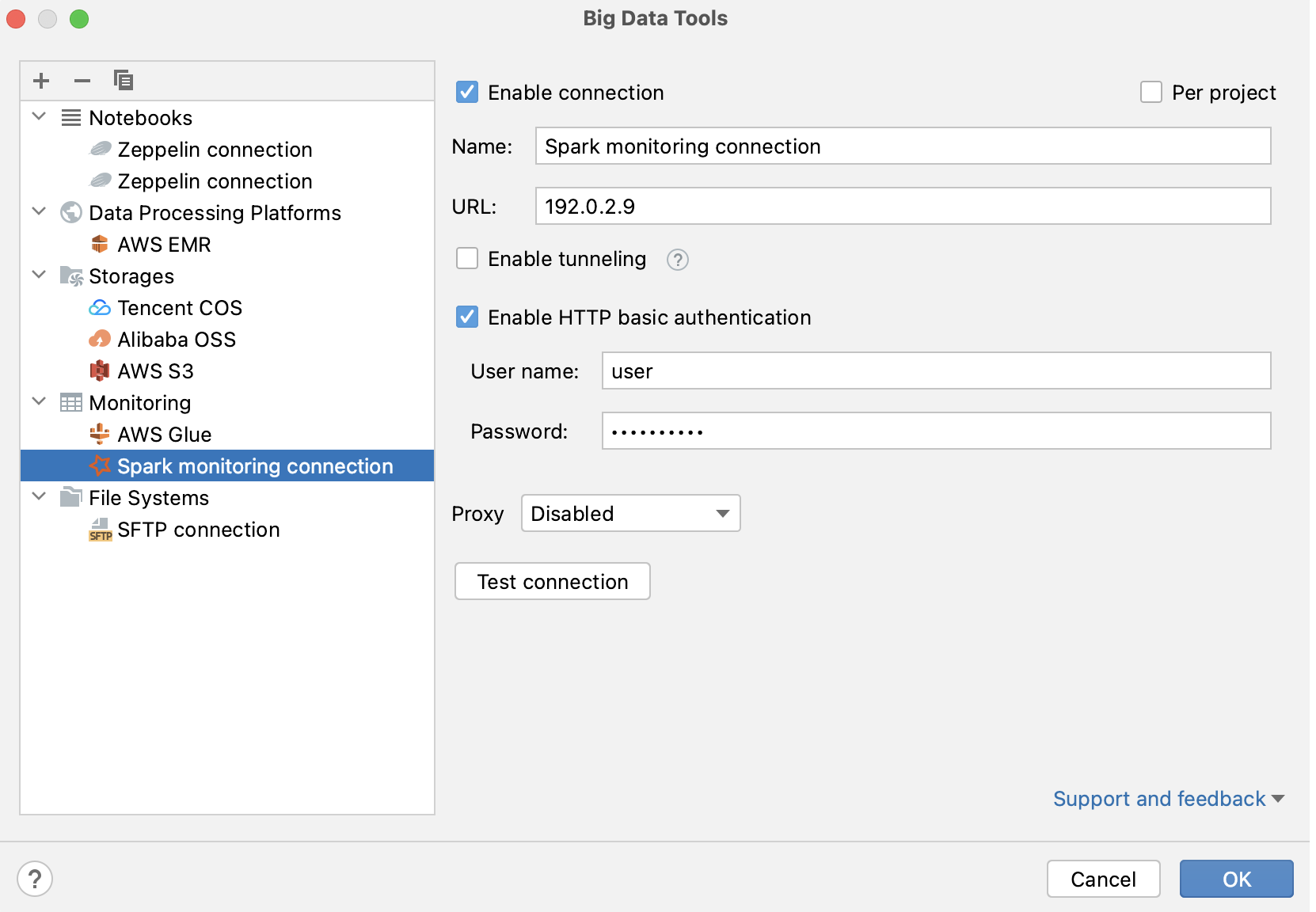

连接到 Spark 服务器

在“大数据工具”窗口中,单击

并选择Spark。

在打开的“大数据工具”对话框中,指定连接参数:

名称:连接的名称,用于区分其他连接。

URL:Spark History 服务器的 URL(通常在端口 18080 上运行)。

您可以选择设置:

每个项目:选择仅为当前项目启用这些连接设置。如果您希望此连接在其他项目中可见,请取消选择它。

启用连接:如果要禁用此连接,请取消选择。默认情况下,启用新创建的连接。

启用隧道:创建到远程主机的 SSH 隧道。如果目标服务器位于专用网络中,但与网络中的主机的 SSH 连接可用,那么它会很有用。

选中该复选框并指定 SSH 连接的配置(单击...以创建新的 SSH 配置)。

启用 HTTP 基本身份验证:使用指定的用户名和密码进行 HTTP 身份验证的连接。

代理:选择是否要使用IDE 代理设置或是否要指定自定义代理设置。

填写设置后,单击测试连接以确保所有配置参数正确。然后单击“确定”。

使用正在运行的作业与 Zeppelin 建立连接

如果您有Zeppelin插件,则可以通过从 Zeppelin 笔记本打开 Spark 作业来快速连接到 Spark 服务器。

在涉及 Spark 的 Zeppelin 笔记本中,运行一个段落。

单击打开作业链接。在打开的通知中,单击更多| 创建连接链接。

如果您已连接到运行作业的 Spark 历史记录服务器,请单击选择连接并从列表中选择它。

在打开的“大数据工具”对话框中,验证连接设置并单击“测试连接”。如果连接成功,单击“确定”完成配置。

建立与 Spark 服务器的连接后,将出现Spark 监控工具窗口。

您可以随时通过以下方式之一打开连接设置:

转到工具| 大数据工具设置页面的IDE设置 。CtrlAlt0S

打开大数据工具工具窗口(视图 | 工具窗口 | 大数据工具),选择 Spark 连接,然后单击

。

单击Spark 监控

工具窗口任意选项卡中的。

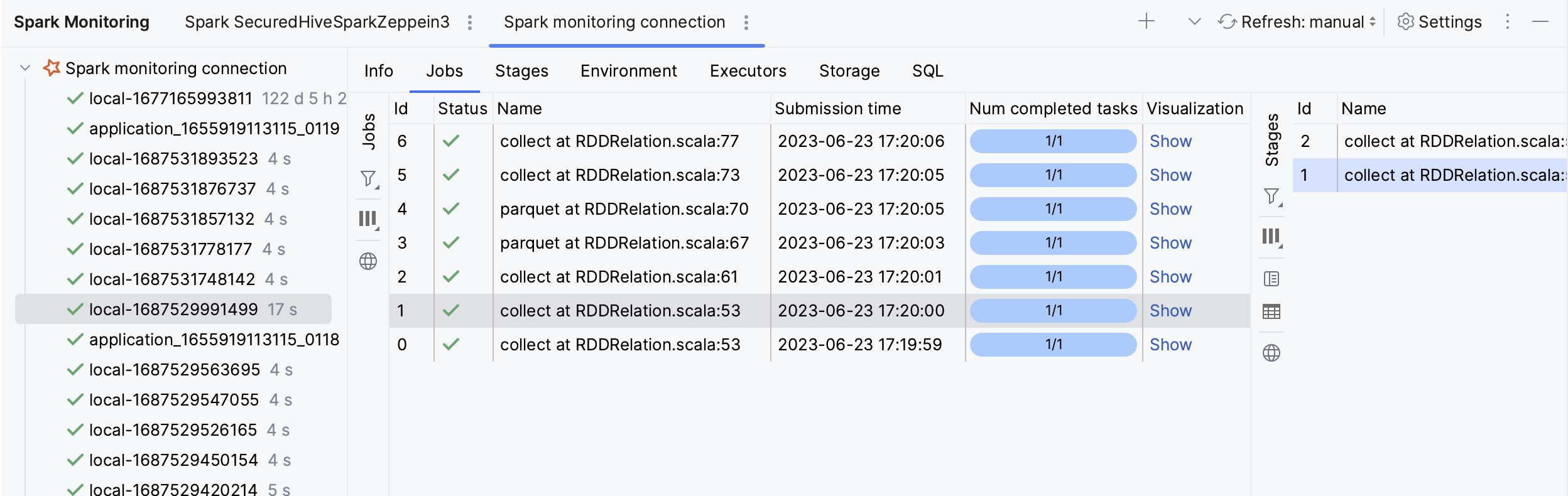

当您在Spark监控工具窗口中选择某个应用程序时,您可以使用以下选项卡来监控数据:

Info:有关已提交应用程序的高级信息,例如 App id 或 Attempt id。

职位:申请职位的摘要。单击某个职位可查看其更多详细信息。使用“可视化”选项卡查看作业 DAG。

阶段:每个阶段的详细信息。

环境:环境和配置变量的值。

执行器:为应用程序启动的进程,用于运行任务并将数据保存在内存或磁盘存储中。使用“日志”选项卡查看执行程序 stdout 和 stderr 日志。

存储:持久化 RDD 和 DataFrame。

SQL:有关 SQL 查询执行的详细信息(如果应用程序使用)。

您还可以预览有关任务的信息,即发送给一个执行者的工作单元。

有关数据类型的更多信息,请参阅Spark 文档。

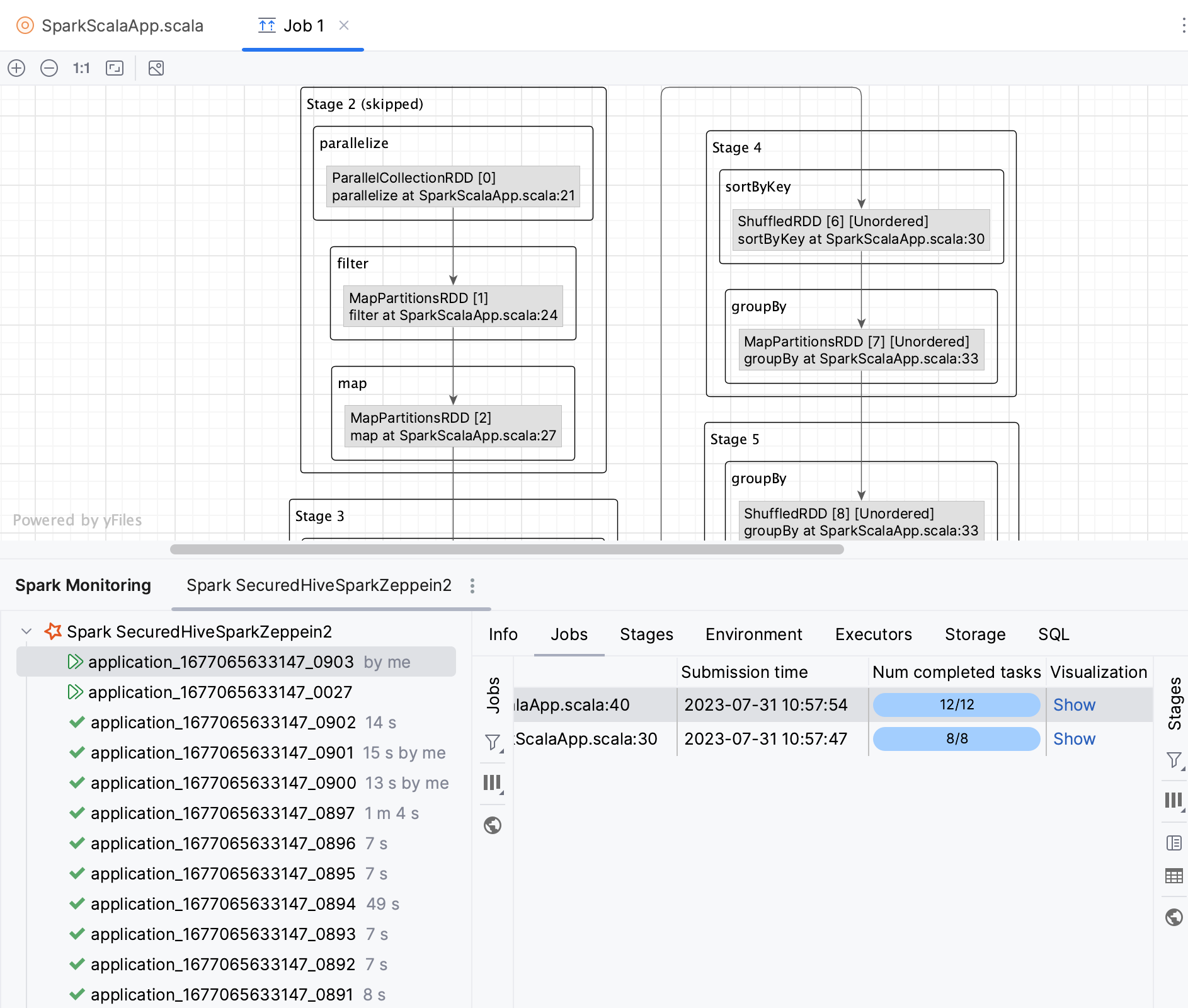

从 DAG 图导航到源代码

DAG(有向无环图)表示 Spark 作业的逻辑执行计划。就像在 Spark UI 中一样,您可以可视化 Spark 作业的 DAG。使用 PyCharm,您还可以快速从 DAG 导航到源文件中相应的代码段。

打开Spark监控工具窗口:查看| 工具窗口 | 火花。

选择一个应用程序并打开“作业”选项卡。

在可视化列中,单击显示。

这将在新的编辑器选项卡中打开作业可视化。

在图表中,双击任意操作。

您将被重定向到您的源代码文件,进行相应的操作。

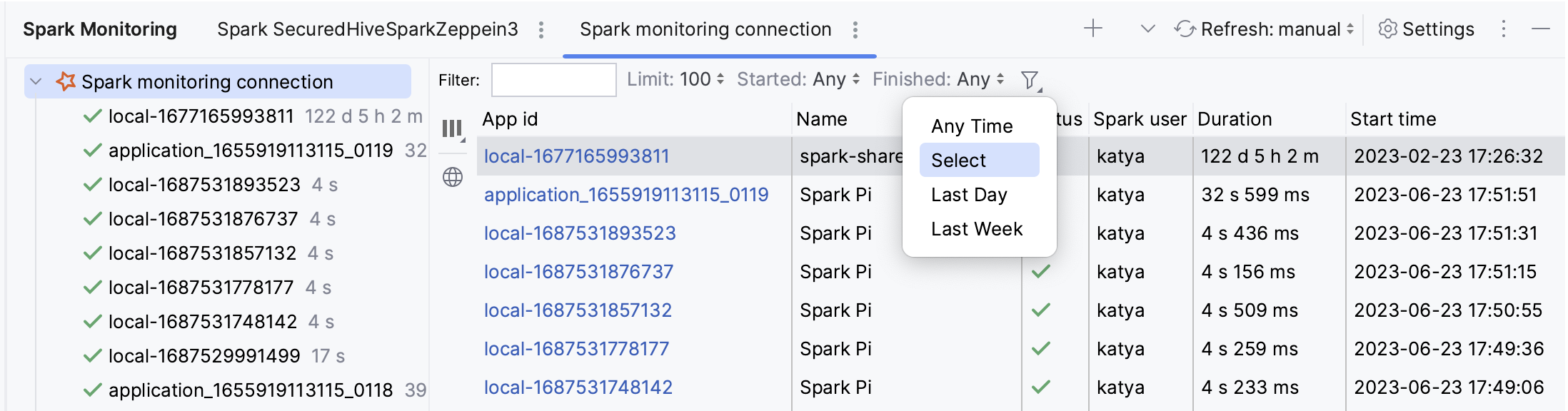

过滤掉监控数据

在Spark监控工具窗口中,使用以下过滤器来过滤应用程序:

过滤器:输入应用程序名称或 ID。

限制:更改显示的应用程序的限制或选择全部以显示所有应用程序。

已开始:按开始时间过滤应用程序或选择任意。

已完成:按完成时间过滤申请或选择“任意”。

:仅显示正在运行或已完成的应用程序。

在Jobs、Stages和SQL选项卡中,您还可以按

状态过滤数据。

您随时可以在Spark监控工具窗口中单击 ,手动刷新监控数据。或者,您可以使用“刷新”按钮旁边的列表配置在特定时间间隔内自动更新。

感谢您的反馈意见!